Zu Gast beim

Elektrischen Reporter

Die Alpha-Geeks sind die ersten, die die Informationsflut spüren und nach Mechanismen suchen, ihr zu entkommen

, meinte ich neulich vor Mario Sixtus laufenden Kameras. Heute ist die Ausgabe![]() erschienen:

erschienen:

Hervorheben möchte ich auch die Folgen mit Peter Glaser![]() , (Teil 2)

, (Teil 2)![]() , Lawrence Lessig

, Lawrence Lessig![]() , (Teil 2)

, (Teil 2)![]() , Bruce Sterling

, Bruce Sterling![]() und – absolutes Prachtstück – Cory Doctorow

und – absolutes Prachtstück – Cory Doctorow![]() .

.

Rivva, vier Supernasen

und das Förderland

Kürzlich stand ich 2x Rede & Antwort zu Rivva:

Letzte Woche hatte ich das Vergnügen, von Mario Sixtus, Nico Lumma + Sebastian Keil zum Klönschnack im Vier-Nasen-tanken-Super-Podcast![]() eingeladen zu werden: MP3 (25:15 Min, 8.7 MB)

eingeladen zu werden: MP3 (25:15 Min, 8.7 MB)

Und heute ist noch ein Interview im Förderland![]() erschienen:

erschienen:

Rivva gestartet

Am 3. habe ich still und heimlich Rivva gelauncht: einen Meme Tracker, der die deutschsprachige Bloglandschaft nach den aktuellen Top-Themen und Diskussionen – kurz: dem Zeitgeist – durchforstet. Mehr zu den Hintergründen auf dem Rivva-Blog …

Zwischen Hypertextroman, Cybertext und Newsletter

Seitdem ich HTML kenne, wollte ich eine Hyperfiction schreiben. Mit dem Rivva-Newsletter bot sich endlich die Chance, das Medium selbst in einen Cybertext zu verwandeln. Ich hatte noch nie davon gehört, dass jemand so etwas versucht hätte.

Und so wurde mein Newsletter zum literarischen Experiment: einen Cybertext in die vertraute Schleife des Newsletters einzuschreiben. Kein Essay, keine Kurzgeschichte, sondern fortlaufende Episoden wie in einem Roman – mit Plot, Wiederkehr und einer Crew, die selbst manchmal nicht weiß, ob sie existiert.

Ich wollte herausfinden: Kann man einen Newsletter so bauen, dass er nicht bloß informiert, sondern sich wie ein Textadventure liest – fragmentiert, verzweigt, verschachtelt?

Wie früher, als HTML noch Handschrift war

Der technische Unterbau ist denkbar simpel: ein Newsletter in HTML.

Aber genau das ist der Trick: <a>-Tags als geheime Portale, CSS-Krümel als Tarnung, absichtlich defekte Links als Anker in die Zukunft, bedingte Inhalte und aleatorische URLs.

Die Grundidee: ein Medium hacken, indem man es wörtlich nimmt.

Newsletter = regelmäßige Signale aus der Meerestiefe.

Leser = Funkstationen an der Oberfläche.

Manchmal kommt Antwort.

Manchmal nicht.

Weltbau & Struktur: Ein Boot, eine Route, ein Seepunkt

Im Zentrum der Erzählung steht ein experimentelles Forschungsboot, gesteuert von einer kleinen Crew auf einer rätselhaften Route entlang einer submarinen Lemniskate – der Spur einer liegenden Acht.

Die Fahrten wirken wie wissenschaftliche Missionen, doch die Realität beginnt zu kippen: Erinnerungslücken, gestörte Protokolle und unmögliche Signale deuten auf eine verborgene Struktur der Reise.

In der Mitte der Acht, dem Seepunkt, beginnen viele Dinge – aber sie enden nicht. Die Schleifen scheinen identisch, aber wiederholen sich nicht exakt. Vergangenheit und Zukunft überlagern sich. Identitäten verschwimmen. Signale verzerren.

Mehr will ich nicht spoilern. Ein gutes Mysterium ist am stärksten, wenn es sich seiner eigenen Logik entzieht. Wie eine Acht: geschlossen – und doch offen in der Mitte. „Das Soufflé fällt nur zusammen, wenn man zu viel erklärt“, würde der Smutje kommentieren.

Die Lemniskate ist nicht nur Setting, sondern Strukturprinzip: Wiederholung ohne Wiederholung, Spiegelungen, Rückkopplungen.

Die Geschichte entfaltet sich fragmentarisch:

- Logbucheinträge, Funksprüche, Systemmeldungen

- ASCII-Glitches und 404-Fehlerseiten

- alternative Fragmente, Nebentexte, Pseudo-Dokumente

- Echos, Wiederholungen, Spiegelungen

- Koordinaten, Anagramme, Zahlencodes (Puzzle-Mechaniken)

Die Reihenfolge verschwimmt. Signale scheinen auf sich selbst zu antworten. Ereignisse widerhallen rückwärts.

Cybertext: Literatur als Maschine

Der Begriff stammt von Espen Aarseth. Cybertexte sind keine bloßen Erzählungen, sie sind Systeme. Man läuft sie ab, arbeitet mit ihnen, statt sie linear zu konsumieren. Die Struktur selbst erzeugt Bedeutung, nicht nur der Inhalt.

Ergodic Reading – Arbeit des Lesers:

Nichtlesen ist eine bewusste Option. Wer weiterkommen will, muss Entscheidungen treffen – und stellt sich den Lesepfad selbst zusammen.Loops, Knoten & Pfade:

Keine lineare Dramaturgie, sondern Schleifen, Selbstreferenzen, visuelle Codes, spekulative Technologie. Zeit ist hier kein Vektor, sondern eine wiederholbare Fläche. Mehrfaches Lesen erzeugt neue Bedeutungsschichten.Undurchsichtigkeit und Stille:

Was ausgelassen wird, spricht mit. Das Fehlen von Information wird Teil der Erzählung – ein „unsichtbares Narrativ“, das Leser mitdenken.

Prinzipien der ergodischen Erzählung

Auf die Arbeit am Text heruntergebrochen, heißt das in der Praxis:

HTML-Anker in die Zukunft setzen:

Versteckte oder kryptische Links, die zunächst ins Nichts führen und erst später aktiviert werden. Auch: interne Anker, die rückwärts verlinken – die Geschichte kennt ihren eigenen Index.In Fragmenten schreiben:

Nicht alles muss aufgelöst werden. Lücken, Auslassungen, offene Enden laden zum Mitdenken ein. Eine Ausgabe nur aus Metadaten, Systemfehlern oder Fragmenten kann dichter wirken als jeder volle Text. Banale Sätze können sich später als Schlüsselstellen entpuppen.Metastruktur als Fundschicht:

Nicht jede Ausgabe ist ein Kapitel, sondern ein Sektor in einem größeren Textkörper. Statt linearer Chronologie entsteht eine Struktur wie ein Datenfund, die Leser schichtweise, lückenhaft, rekonstruierbar entdecken.Negative Space ≙ Pausen in der Musik:

Absenz erzeugt Spannung. Eine Episode ohne Signal ist selbst ein Erzählelement. Schweigen, Abbruch, fehlende IDs können spannender sein als jeder volle Absatz.

Fiktion, Spiel, Interface & Lesererfahrung

Cybertexte machen aus Konsumenten Mitproduzenten – und mitunter sogar Mitautoren einer Welt.

- Als immersives Format:

Wer aufmerksam liest, wird zum Entdecker. - Als digitales Kunstobjekt:

Jedes Fragment, jeder 404-Link wird Teil eines Gesamtkunstwerks. - Als Einladung zum Mitspielen:

Leser schreiben mit – durch Erinnerung, Klicks, Schweigen.

Resonanzliteratur: Die Story als Spiegel

Gestartet als klassischer Newsletter, transmutierte die Form langsam zu einer semiotischen Tauchausrüstung für Fortgeschrittene.

Ich wollte den Zustand des Internets selbst spiegeln in eine narrative Struktur, die ihn zugleich dokumentiert, beklagt und unterwandert – eine kleine Allegorie über Bewusstsein, Identität, Resonanz und die Verwischung zwischen Mensch, Maschine und Publikum.

Die Crew – Funkerin, Roboto, Wissenschaftsoffizierin – wurde zur Metapher: ihre Stimmen standen für das Überhören, Vergessen, Verstummen. Statt laut zu senden, legte der Text Schweigen frei – als verdichtetes Signal.

So wurde das Experiment zur Parabel über Resonanz: Jede nicht geöffnete E-Mail, jeder nicht geklickte Link wurde Teil der Erzählung. Das Boot wusste am Ende nicht: Ist niemand da oben – oder hört niemand hin?

Die Fiktion spiegelt den Zustand kleiner Internetprojekte im Rauschen.

Vergessen ≙ Aufmerksamkeitsverlust.

Mit Tiefe zu enden heißt nicht, abgeschlossen zu sein – sondern unerreichbar geworden.

Ein Nachklang, wie Musik ohne Instrument.

Ein Echo eines Echos.

Die Form überlebt den Inhalt.

Eine Lemniskate (∞) aus Text.

Wer noch einmal eintauchen möchte:

Das Newsletter-Archiv versammelt alle Ausgaben und ihre versteckten Pfade.

Und hier erzähle ich über die Idee und den Entstehungsprozess: Die Schleife war die Nachricht.

Links

- Jorge Luis Borges … eine Bibliothek voller Cybertext-Ideen

- Julio Cortázar: Rayuela (1963/1981)

- Michael Joyce: afternoon, a story (1987/2020)

- Michael Joyce: Twelve Blue (1996)

- Espen Aarseth: Cybertext: Perspectives on Ergodic Literature (1997)

- Mark Z. Danielewski: House of Leaves (2000)

- Alexandra Saemmer: Böhmische Dörfer (2011)

- Steven Johnson: Why No One Clicked on the Great Hypertext Story

(2013)

(2013)

Rails Rivva

Wollte mal sehen, ob sich Rivva auch dazu eignet, z. B. RoR-Blogs zu verfolgen.

Das Ergebnis haut mich noch nicht um, doch selbst Rivva #1 hat eine Weile zum Einschwingen gebraucht …

Nun denn: http://rails.rivva.de![]()

Gespräch mit einem Blogpiloten

Noch ein Interview: Diese Woche mit Thomas Gigold über Rivva, Ruby on Rails und das neue Web.

Noch ein Interview: Diese Woche mit Thomas Gigold über Rivva, Ruby on Rails und das neue Web.

In other News: Mit Joyent Slingshot![]() sollen Ruby-on-Rails-Apps offline laufen und à la Apollo

sollen Ruby-on-Rails-Apps offline laufen und à la Apollo![]() die Brücke zum Desktop schlagen. Game Changer!

die Brücke zum Desktop schlagen. Game Changer!

Gnip, bitte nur ein Ping

Hierzulande viel zu wenig Beachtung gefunden hat in meinen Augen der Stapellauf von Gnip![]() letzte Woche.

letzte Woche.

Selten kommt ein neuer Service daher, der das Remixen und Mæshen so stark vereinfacht und damit weitergehend demokratisieren wird. Letztes Jahr war es Yahoo! Pipes![]() , 2008 könnte es Gnip werden. War das Motto der Pipes (and Filters) jedoch Mashups für den Rest von uns, werden die meisten Menschen Gnip nie zu Gesicht bekommen. Jedenfalls solange Gnip nur seinen Job erledigt. Denn Gnip will stromaufwärts notwendige moderne Infrastruktur 2.0 bereitstellen.

, 2008 könnte es Gnip werden. War das Motto der Pipes (and Filters) jedoch Mashups für den Rest von uns, werden die meisten Menschen Gnip nie zu Gesicht bekommen. Jedenfalls solange Gnip nur seinen Job erledigt. Denn Gnip will stromaufwärts notwendige moderne Infrastruktur 2.0 bereitstellen.

Was macht Gnip?

Gnip möchte als Nachrichtenbus agieren für Micro-Content aller Art aus allen möglichen Social-Media-Plattformen. Man möchte den Datenfluss zwischen diversen Anwendungen so einfach und portabel![]() wie möglich gestalten und zwar für die Produzentenseite gleichermaßen wie für die anschließenden Konsumenten.

wie möglich gestalten und zwar für die Produzentenseite gleichermaßen wie für die anschließenden Konsumenten.

In anderen Worten: Gnip will uns ermächtigen![]() , FriendFeed innerhalb von einem Nachmittag nachzuprogrammieren.

, FriendFeed innerhalb von einem Nachmittag nachzuprogrammieren.

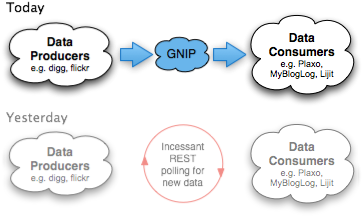

Warum das heutige Aggregationsmodell für Social Media nicht skaliert

Wer heute angebotene Dienste über Web-/REST-APIs oder RSS-/Atom-/JSON-Feeds remixen möchte (grundlegendes zum Thema Mashups), sieht sich folgendem Dilemma ausgesetzt:

- Wir können Datenquellen entweder relativ häufig pollen, um von etwaigen Änderungen schnellstmöglich zu profitieren.

- Oder uns und unserem Gegenüber eine riesige Menge redundanter Anfragen und damit enorme Bandbreite sparen, indem wir größere Latenzzeiten zwischen unseren Anfragen einhalten.

Der Kompromiss besteht zwischen wünschenswerter Aktualität und hoher Informationseffizienz. Ein Twitter-Status, dass ein paar Freunde gerade am Elbstrand Bier + Sonne tanken, ist beispielsweise nicht mehr von besonders hohem Wert, wenn wir die Nachricht zu spät erhalten. Die Gefahr im Gegenzug ist aber, den Anbieter durch eine zu hohe Polling-Frequenz Hast Du wat Neues für mich? … Hey, schon wat Neues? … Jetzt? – jetzt vielleicht wat Neues?

zu überlasten, um dann wahrscheinlich gedrosselt oder womöglich sogar gesperrt zu werden. Beide Seiten verlieren! Daten wollen reisen, Daten wollen frei sein.

Die Crux ist also, die Polling-Frequenz der Änderungsrate auf der Gegenseite anzunähern: einerseits nichts zu verpassen, andererseits aber auch nicht zu drängeln.

Diese Problematik stellt sich bei News-Aggregatoren wie meinem Rivva genauso wie bei Lifestreaming-Diensten wie FriendFeed![]() oder beim ganz normalen Abholen und Lesen der eigenen Feed-Abos. Doch das Problem wächst exponentiell … denn sowohl die Menge remixbarer Quellen als auch die Anzahl vermanschbarer Aktivitätsströme werden über die nächsten Jahre in wohl dramatischer Weise zunehmen.

oder beim ganz normalen Abholen und Lesen der eigenen Feed-Abos. Doch das Problem wächst exponentiell … denn sowohl die Menge remixbarer Quellen als auch die Anzahl vermanschbarer Aktivitätsströme werden über die nächsten Jahre in wohl dramatischer Weise zunehmen.

In FriendFeed lassen sich heute beispielsweise nur 41 der populärsten Dienste einspeisen. Das sind nicht nur viel zu wenig Möglichkeiten, nein, die Sicht ist auch noch viel zu US-zentrisch und schon in einem Jahr wird es Hunderte weiterer relevanter Services geben. Wenn uns das Kreuzprodukt aus x Diensten * y Nutzer * z Updates pro Stunde hier keinen Strich durch die Rechnung machen würde, bräuchte es sowas wie Gnip nicht. Und mindestens einstündliche Updates sind für viele Anwendungen noch das absolute Minimum. Fürs massentaugliche Live-Web versagt dieses Modell ziemlich rasch.

Invertierung der Datenströme – von Pull zu Push

Gnip nun stellt sich als Mittelsmann zwischen die wertschaffenden Content-Plattformen und die davon wertschöpfenden Media-Aggregatoren. Zwei der Launch-Partner sind zum Beispiel Digg und Plaxo: Diggt jetzt jemand eine Story, soll diese Aktivität binnen 60 Sekunden bei Plaxo Pulse erscheinen.

Möglich werden die Nahezu-Echtzeit-Updates, indem man dem Pub/Sub-Modell folgt: Gnip sammelt die Aktivitätsströme an zunächst zentral organisierter Stelle (später solls mal dezentral werden) und verteilt sie sofort an seine Liste von Empfängern.

Die Notifikation kann produzenten- wie konsumentenseitig via Pull oder Push erfolgen. Insbesondere im Push-Mechanismus sehe ich die ermöglichende Schlüsseltechnologie für diverse neue Anwendungen, vor allem aber auch für kleinere Dienste wie Rivva, die sich eine kostspieligere Infrastruktur auch gar nicht leisten könnten.

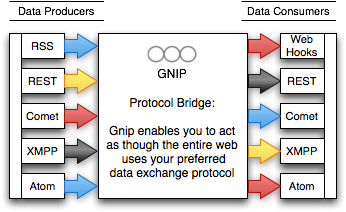

Bridging zwischen verschiedenen Protokollen und Formaten

Gut gefällt mir dabei die Protokollbrücke: wie man als Quasi-Babelfisch zwischen verschiedenen Ein-/Ausgabe-Formaten und -Protokollen übersetzt: Zur Eingabe dienen XMPP, Atom, RSS und REST. Zur Ausgabe kommt derzeit nur Atom via REST zum Tragen, der Rest soll zu einem späteren Zeitpunkt folgen.

Getreu dem Motto Release Early hat man sich zum Start auf die reine Benachrichtigung zwischen Punkt A und Punkt B konzentriert, der tatsächliche Datenaustausch soll später kommen.

Hohe Datenportabilität durch standardisierte Metadaten

Weitere Karma-Punkte sammelt Gnip für die anbieterübergreifende Standardisierung der verschiedenen Semantiken in den Activity Streams. Hier war man so gut beraten, Chris Messina und seine Arbeit im DiSo-Projekt![]() zu integrieren. Die Gnip API beschreibt, wie unterschiedliche Datenformate nach einer XSLT in einem normalisierten Activity XML

zu integrieren. Die Gnip API beschreibt, wie unterschiedliche Datenformate nach einer XSLT in einem normalisierten Activity XML![]() konsumiert werden können.

konsumiert werden können.

Sehr schön, wie die Gnips auf Standards setzen, wo immer dies möglich war. Kein Mashup-Entwickler dieser Welt wirds vermissen, für jeden anzubindenden Dienst eine kleine Extrawurst programmieren zu müssen.

Summa Summarum

Alles in allem könnte Gnip vielleicht zu so zentraler Wichtigkeit gelangen wie der Push Notification Service fürs iPhone. Die Sterne stehen gut.

Um das Akamai für Web-Services zu werden, müssen sie natürlich noch unter Beweis stellen, dass sie auch hohe Lastspitzen mühelos überstehen. Look Ma, no SQL database![]() zeugt von einem guten Omen.

zeugt von einem guten Omen.

Showstopper könnte allerdings die rechtliche und insbesondere politische Sachlage werden. APIs sind der neue Klebstoff. Wer sein API in die Hände eines Dritten gibt, tritt damit auch einen Großteil seiner Kontrolle darüber ab. Dass Twitter diesen Schritt machen wird, glaube ich mal nicht.

Update: bin begeistert, Twitter spielt wider Erwarten doch Gnip Gnop![]()

Update #2: Sebastian Keil, Marcel Weiß und ich haben Gnip auf Kanal 14![]() näher analysiert.

näher analysiert.